Naive 中文的問題,我們搜遍了碩博士論文和台灣出版的書籍,推薦黃志勝寫的 機器學習的統計基礎:深度學習背後的核心技術 和梁棟,張兆靜,彭木根的 大數據X資料探勘X智慧營運都 可以從中找到所需的評價。

另外網站Restoring native predators can control invasive species也說明:A pine marten on the Crom Estate in Northern Ireland. Joshua P Twining, Author provided. Naive prey and versatile predators. From wolves hunting ...

這兩本書分別來自旗標 和崧燁文化所出版 。

銘傳大學 醫療資訊與管理學系健康產業管理碩士班 林志銘所指導 邱昰桓的 勞工高尿酸血症相關因子與機器學習預測評估 (2021),提出Naive 中文關鍵因素是什麼,來自於高尿酸血症、痛風、統計分析、機器學習、預測模型。

而第二篇論文元智大學 資訊工程學系 周志岳所指導 莊子毅的 學生課後自評心得分類機制之實作與實務議題探究:無意義資料、不平衡資料、與多重標籤資料 (2021),提出因為有 自然語言處理、無意義資料、不平衡資料、多重標籤資料、機器學習、資料處理、分類模型的重點而找出了 Naive 中文的解答。

最後網站naive - 英汉词典在线翻译則補充:英孚在线翻译为您提供naive的中文翻译,资料和例句,naive的中文准确说法等英语服务,帮助您更好的学习英语是我们的乐趣。

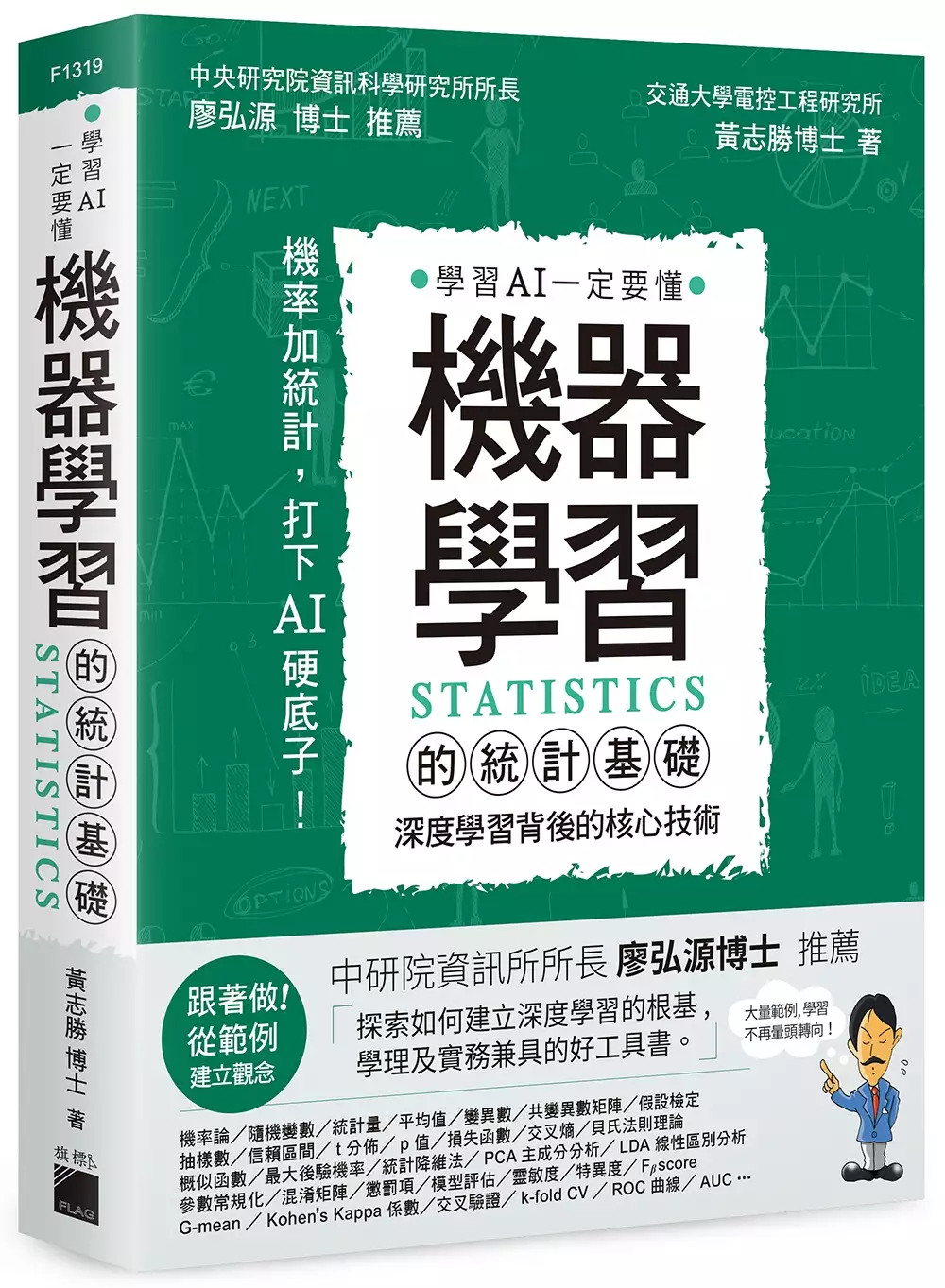

機器學習的統計基礎:深度學習背後的核心技術

為了解決Naive 中文 的問題,作者黃志勝 這樣論述:

「作者在上市 IC 公司上班,每天面對 real world problems。探索如何建立輕量深度學習網路以及發展更有效率的學習方式是他每天的工作。這是一本學理及實務兼具的好工具書。」 - 中央研究院資訊科學研究所所長 廖弘源博士 推薦 [搭起 AI 與統計的橋樑] 原本統計學與人工智慧是兩個完全不同的領域,然而兩者在近代都有了新的發展進而產生連結。在人工智慧中導入機率與統計的觀念,讓電腦具有自己找出數據之間的關聯性並試圖解決問題的能力,因而出現機器學習 (machine learning) ,再加上電腦計算能力的大幅提升,解決多層類神經網路和大數據之間聯

繫性的可能,進而衍生出現今最熱門的深度學習 (deep learning)。 不過,大部分電腦相關科系出身的人並不熟悉統計學,因此在更上一層樓的時候容易遇到障礙。有鑒於此,小編在推出《機器學習的數學基礎》(天瓏專業書店年度暢銷第一名) 一書之後,就積極開發 AI 與統計學相關的書籍。在尋尋覓覓之後請到擅長統計與機器學習的黃志勝博士出馬撰寫《機器學習的統計基礎》,首要之務就是讓讀者不要視統計為畏途,因此在書中設計大量範例以降低學習難度,務求讀得懂、做得出來才容易吸收,進而搭好統計與機器學習的橋樑。如果自覺數學已經還給老師了也不用擔心,可以將本書搭配《機器學習的數學基礎》一併完整學習。

[學會統計,由混亂到清晰] 本書從讀者在高中就學過的集合與機率論開始,帶您快速複習一遍,並將容易混淆之處多多舉例說明,並將以前似懂非懂的隨機變數、機率分布等觀念再解釋得更清楚。接下來就進入專有名詞特別多的統計學,這也是造成許多人暈頭轉向之處。特別是樣本估計、信賴區間、顯著水準、信心水準、t-分布、假設檢定...等讓人一個頭兩個大的主題,更是務求清楚明瞭。當然本書不可能把完整的統計學全都搬進來,此處只介紹機器學習、深度學習需要用到的統計基礎知識,縮短您的學習時間。 然後就進入機器學習的重頭戲,從資料前處理到迴歸、分類模型的建立,以及當數據的特徵數過多時的 PCA、LDA 統計降維法

。從類神經網路開始進入深度學習的範疇,包括前向傳遞、梯度下降法與倒傳遞學習法的手算實作,幫助讀者一步步建立深度學習的演算邏輯,並利用參數常規化解決模型過擬合 (over-fitting) 的問題。最後,導入模型評估,例如二元、多元分類模型評估指標、迴歸模型評估指標、4 種交叉驗證的方法,做為判斷模型好壞的參考依據。 相信讀者認真看完本書後,一定能建立起機器學習結合統計學的硬底子。當然這只是開端,期望讀者以本書為基石繼續前行。 本書特色 1. 打好機率與統計的基礎,快速釐清讓人容易暈頭轉向的統計理論。 2. 藉由大量範例說明,務求讀得懂、做得出來,才容易吸收。 3. 作者提

供專屬讀者天地,以及機器學習方面的文章供後續學習。

Naive 中文進入發燒排行的影片

前國家主席江澤民曾在電視鏡頭面前批評香港記者too young, sometimes naive,讓許多人都注意了naive這個字。這字用作貶詞,是幼稚無知、頭腦簡單的意思,如: 一、I can't believe you were so naive as to trust him.

勞工高尿酸血症相關因子與機器學習預測評估

為了解決Naive 中文 的問題,作者邱昰桓 這樣論述:

研究背景:機器學習是一種不需顧慮變項間交互作用的一種疾病預測方法。而高尿酸血症是各種慢性疾病的生物指標之一,然而在2011年起我國政府所提供的常規健康檢查卻取消了尿酸的檢測。研究目的:透過機器學習的方法鑑別高尿酸血症的相關因子,並建立用於健康檢查的篩檢預測工具。研究方法:本研究數據來自於台灣北部某醫院的勞工健康檢查,使用迴歸分析找尋相關因子,並藉由迴歸係數估計因子對於尿酸的影響程度。機器學習部分則是利用10種之分類器,分別是羅吉斯迴歸、引導聚集算法、隨機森林、支持向量機、K-近鄰演算法、高斯單純貝氏分類器、梯度提升技術、自適應增強學習、極限梯度提升與多層感知器等十種分類器建立模型,並利用混淆

矩陣對模型的性能進行評估和比較,也使用Shapley additive explanation value (SHAP) 選擇重要特徵值。研究結果:3,667名參與者中有897 人患高尿酸血症,尿酸異常相關因子為年齡、性別、代謝症候群嚴重度指標、身體質量指數與肌酸酐。機器學習過程使用 4,319 筆經處理過的數據,利用SHAP值進行重要特徵值選擇,對尿酸異常的影響依序為肌酸酐與代謝症候群嚴重程度指標等。最佳模型為羅吉斯迴歸和梯度提升技術,兩者的模型的曲線下面積均為 0.78,若只使用排序前兩個主要特徵再次模型訓縣,其預測能力與原始模型相似。研究結論:高尿酸血症主要影響因子為肌酸酐及代謝症候群嚴

重度指標,我們可利用這兩個變項在健康檢查當中進行初步的高尿酸血症檢。本研究提供一種低成本且即時性的工具進行勞工高尿酸血症的預測,擴大研究對象、預測變數與進行前瞻性設計,並進一步提升模型鑑別能力。

大數據X資料探勘X智慧營運

為了解決Naive 中文 的問題,作者梁棟,張兆靜,彭木根 這樣論述:

【想深入了解大數據、資料探勘的讀者請進!!】 什麼是資料前處理? 電信業者跟資料探勘有什麼關係? 神經網路具體到底是什麼? 集群分析的演算法有哪些? ◎資料探勘的「十大經典演算法」你都認識嗎? 國際權威的學術組織the IEEE International Conference on Data Mining (ICDM)評出了資料探勘領域的十大經典演算法:C4.5、K-Means、SVM、Apriori、EM、PageRank、AdaBoost、KNN、Naive Bayes和CART。 1.C4.5演算法 C4.5是一種用在機器學習和資料探勘領域的分類問題中的演算

法。它基於以下假設:給定一個資料集,其中的每一個元組都能用一組屬性值來描述,每一個元組屬於一個互斥的類別中的某一類。C4.5的目標是透過學習,找到一個從屬性值到類別的映射關係,並且這個映射能用於對新的類別未知的實體進行分類。 2.The K-Means Algorithm (K-Means演算法) K-MeansAlgorithm是一種聚類演算法,它把n個對象根據他們的屬性分為k個分割,k ◎結構化/半結構化/非結構化資料有什麼不同? (一)結構化資料:能夠用數據或統一的結構加以表示的資料,如數字、符號。傳統的關係資料模型,儲存於資料庫,通常可用二維表結構表示。 (二

)非結構化資料:是指其欄位長度可變,並且每個欄位的記錄又可以由可重複或不可重複的子欄位構成的資料庫,用它不僅可以處理結構化資料(如數字、符號等資訊)而且更適合處理非結構化資料(全文文字、圖像、聲音、影視、超媒體等資訊)。 (三)半結構化資料: XML、HTML文檔就屬於半結構化資料。它一般是自描述的,資料結構和內容混在一起,沒有明顯的區分。 ◎如何設計神經網路的拓撲結構? 在開始訓練之前,用戶必須確定網路拓撲,說明輸入層的單元數、隱藏層數(如果多於一層)、每個隱藏層的單元數和輸出層的單元數。 對訓練元組中每個屬性的輸入測量值進行規範化將有助於加快學習過程。通常,對輸入值規

範化,使得它們落入0.0和1.0之間。離散值屬性可以重新編碼,使得每個域值有一個輸入單元。例如,如果屬性A有3個可能的或已知的值{a0,a1,a2}則可以分配三個輸入單元表示A,即我們可以用I0,I1,I2作為輸入單元。每個單元都初始化為0。如果A=a0,則I0置為1,其餘為0;如果A=a1,則I1置1,其餘為0;諸如此類。 神經網路可以用於分類(預測給定元組的類標號)和數值預測(預測連續值輸出)。對於分類,一個輸出單元可以用來表示兩個類(其中值1代表一個類,而值0代表另一個類)。如果多於兩個類,則每個類使用一個輸出單元。 全書特色 全書分為九章,內容包括:大資料探勘與智慧營運的

概念,資料前處理,資料探勘中的四種主流演算法:集群分析、分類分析、迴歸分析、關聯分析,增強型資料探勘演算法,資料探勘在營運商智慧營運中的應用案例,未來大資料探勘的發展趨勢等。主要提供給電信業者及其他高科技企業員工、大專院校學生和研究生,以及其他對資料探勘與精準行銷感興趣的讀者。

學生課後自評心得分類機制之實作與實務議題探究:無意義資料、不平衡資料、與多重標籤資料

為了解決Naive 中文 的問題,作者莊子毅 這樣論述:

學生課後對老師教學或是自我學習狀況的自評心得是讓教育者了解學生學習狀況以及改善其教育品質的常用管道。不過學生所寫的心得通常會涵蓋很多面向與充滿著不同情感,而要以人工閱讀這些大量心得非常耗時費力。為此,有些研究學者透過建構基於機器學習或神經網路架構的分類模型來快速地分析大量自評心得。然而運用機器學習分類技術建構分類模型的研究通常會對資料進行預先處理,像是排除一些無意義資料或重整資料成平衡資料,或是將具備多重標籤的資料拆成多筆單一標籤資料。但實際運用分類模型來分類學生自評心得的實務卻面臨要分類無意義資料、不平衡資料、以及多重標籤資料。本研究探究實務上無意義資料、不平衡資料以及多重標籤資料三個因子

對於學生自評心得機制分類準確性的影響。本研究收集了2060筆特定課程的學生課後自評心得並經由研究人員標記,分類成七個主題類別和三個情感類別。本研究計算並比較是否包括無意義資料、不平衡資料或平衡資料、多重標籤資料或單一標籤資料等不同組合的資料集,在多種文字處理技術以及使用多種分類模型的分類準確性,探究三個因子對其分類準確性評估指標的影響。研究結果顯示不包括無意義資料的平均分類正確率為0.681,而包括無意義資料的平均分類正確率為0.624。採用不平衡資料的平均分類正確率為0.573,而採用平衡後資料的平均分類正確率為0.732。只採用單一標籤資料的平均分類正確率為0.796,而納入多重標籤資料的

平均分類正確率為0.764。其中,使用BERT預訓練模型在有資料平衡且無其他類別的單標籤分類的正確率可以達0.923。

想知道Naive 中文更多一定要看下面主題

Naive 中文的網路口碑排行榜

-

#1.naive-ui/README.zh-CN.md at main - GitHub

Naive UI. 一个Vue 3 组件库. 比较完整,主题可调,使用TypeScript,快. 有点意思. English | 中文. 文档. www.naiveui.com. 社区. Discord; 钉钉一群33482509 (已满) ... 於 github.com -

#2.英语-汉语naive翻译

'naive'在免费英语-汉语词典的翻译,查看更多汉语的翻译。 於 www.babla.cn -

#3.Restoring native predators can control invasive species

A pine marten on the Crom Estate in Northern Ireland. Joshua P Twining, Author provided. Naive prey and versatile predators. From wolves hunting ... 於 climate.to -

#4.naive - 英汉词典在线翻译

英孚在线翻译为您提供naive的中文翻译,资料和例句,naive的中文准确说法等英语服务,帮助您更好的学习英语是我们的乐趣。 於 center.ef.com.cn -

#5.네이버 영어사전

미국/영국식 발음, 여러 종류의 출판사 사전 뜻풀이, 풍부한 유의어/반의어, 대표사전 설정 기능, 상세검색 기능, 영어 단어장 제공. 於 en.dict.naver.com -

#6.夏志清夏濟安書信集:卷四(1959-1962) - 第 194 頁 - Google 圖書結果

中國人naive講故事的味道喪失殆盡,他只求slick。五四以後,暫時不管,我已買到《駱駝 ... 這班學生(人數大約不會多)因為不懂中文,如單教五四以後的,反而有選材的困難。 於 books.google.com.tw -

#7.Naive Systems | 领英

Naive Systems | 在领英上有17 位关注者。Delivering top-tier software systems to worldwide customers. 於 cn.linkedin.com -

#8.naive的意思在线翻译,解释naive中文英文含义,短语词组,音标 ...

[哲]朴素唯物主义。 na.ive 或na.?ve. naive的音标和读音: DJ音标发音 ... 於 odict.net -

#9.naive 中文意思是什麼

naive 中文 意思是什麼 ... adj. 形容詞 天真的;自然的,樸素的;憨厚的。 ... 現在以寫作naive 較普通。 adv. 動詞 副詞 -ly n. 名詞 -ness adj. 形容詞 天真的;自然的,樸素的 ... 於 terryl.in -

#10.Naive 歌詞陳珊妮※ Mojim.com

Naive 電影【她媽媽的公主My Little Princess 】中文主題曲作詞:陳珊妮作曲:陳珊妮天有天懂的風雲就像你自有你的神韻月有月沉溺的缺越凝視越是看不清雲有雲懂的秩序 ... 於 mojim.com -

#11.NAIVE-Selfridges | 网上购物

购买NAIVE 从我们的空部门为广泛的范围的空范围NAIVE 空| 可从Selfridges.com 在线选 ... 简体中文; 英语; 英语; 英语; 英语; 简体中文; 英语; 英语; 英语; 简体中文 ... 於 www.selfridges.com -

#12.naive中文意思是什麼? 這裡有正確翻譯答案 - 線上文字產生器

提供英文單字naive的中文意思及正確翻譯包括詞性用法. 於 www.touched.cc -

#13.NAIVE 中文是什么意思- 中文翻译 - Tr-ex

NAIVE ”的语境翻译在英语-中文。以下是许多翻译的例句,其中包含“NAIVE” - 英语-中文翻译和搜索引擎英语翻译。 於 tr-ex.me -

#14.China on the UN Human Rights Council raises concern ...

... the Soviet Union that the liberal international order would become the norm for all but it has not and it was naive to think it would. 於 www.rcinet.ca -

#15.法语naive在线翻译成中文 - 有道词典

Naive et vraie, elle se laissait aller a sa nature angelique sans se defier ni de ses impressions, ni de ses sentiments. 她天真而坦诚,听凭纯洁的天性纵横 ... 於 dict.youdao.com -

#16.medication-naive中文意思_百度知道

medication-naive中文意思 · 其他类似问题 · 为你推荐: · 特别推荐 · 等你来答. 於 zhidao.baidu.com -

#17.naive是什么意思 - 英语词典

恒星英语词典栏目提供naive是什么意思,naive的中文解释,naive的读音发音,naive的含义和用法以及naive的造句参考例句。 於 danci.hxen.com -

#18.naive 考研专八 - 欧路词典

『欧路词典』为您提供naive的用法讲解,告诉您准确全面的naive的中文意思,naive的读音,naive的同义词,naive的反义词,naive的例句。 於 dict.eudic.net -

#19.Naive Plus e-Passbook - Google Play 應用程式

Naive Plus e-Passbook is used to view transactions pertains to a customer. Naive Plus電子存摺用於查看與客戶有關的交易. 閱讀完整內容. 於 play.google.com -

#20.naive-翻译为中文-例句英语

使用Reverso Context: naïve, being naive,在英语-中文情境中翻译"naive" 於 context.reverso.net -

#21.naïve - 維基詞典,自由的多語言詞典

英語編輯. 形容詞編輯. naïve(比較級 naïver 或more naïve,最高級 naïvest 或most naïve). naive 的另一種拼寫法. 派生詞編輯 · naïvely · naïveness · naïveté ... 於 zh.m.wiktionary.org -

#22.英文期刊查詢- 數位典藏 - 交通部運輸研究所

篇名, Naive Diversification Strategies in Defined Contribution Saving Plans. 簡稱, AER. 作者, Shlomo Benartzi and Richard H. 於 www.iot.gov.tw -

#23."too young to naive "用中文(繁體,臺灣) 要怎麼說? | HiNative

有關中文(繁體,臺灣) 的問題. too young to naive 用中文(繁體,臺灣) 要怎麼說? ... 妳的意思是too young ,too naive嗎? too...to... 太...而不. 於 tw.hinative.com -

#24.7/22《她媽媽的公主》電影中文主題曲-陳珊妮《Naive》120秒

《Naive》歌詞:天有天懂的風雲就像你自有你的神韻月有月沉溺的缺越凝視越是看不清雲 ... 7/22《她媽媽的公主》電影中文主題曲-陳珊妮《Naive》120秒. 於 www.youtube.com -

#25.记住:"不要太幼稚了!"不是"Don't be naive!"(音频版) - 搜狐

记住:"不要太幼稚了!"不是"Don't be naive!"(音频版) · 英语口语 · 吉米老师前言: · 结尾音乐:La La La · babyish/childish · adolescent. 於 www.sohu.com -

#26.naive 中文意思是什麼 - Dict.site 英漢/漢英線上英文字典

adj. 形容詞 天真的;自然的,樸素的;憨厚的。 · 現在以寫作naive 較普通。 ; adv. 動詞 · -ly ; n. · 名詞 -ness ; adj. 形容詞 天真的;自然的,樸素的;憨厚的。 · 現在以寫作 ... 於 dict.site -

#27.知識與行動:中華文化傳統的社會心理詮釋 - 第 90 頁 - Google 圖書結果

... 翻譯成中文,檢驗一下信、效度,也可以「加工製造」出一篇篇的論文。結果「邏輯實證主義」到台灣之後,變成了只有「實證」而沒有「邏輯」的「素樸實證主義」(naive ... 於 books.google.com.tw -

#28.Naive Bayesian classifier for rapid assignment of rRNA ...

The Ribosomal Database Project (RDP) Classifier, a naïve Bayesian classifier, can rapidly and accurately classify bacterial 16S rRNA sequences into the new ... 於 pubmed.ncbi.nlm.nih.gov -

#29.Naive的中文翻譯

7/5000. 偵測語言, 世界語, 中文, 丹麥文, 亞塞拜然文, 亞美尼亞文, 伊博文, 俄文, 保加利亞文, 信德文, 優魯巴文, 克林貢語, 克羅埃西亞文, 冰島文, 加泰羅尼亞文 ... 於 zhcnt4.ilovetranslation.com -

#30.Naive - The Kooks - KKBOX

繁體中文, English. 繁體中文. 繁體中文. English. 台灣, 香港, 日本 · 新加坡 · 馬來西亞. 香港. 香港. 台灣日本新加坡馬來西亞. 電訊合作夥伴:. 於 www.kkbox.com -

#31.naive的中文翻譯和情景例句- 留聲詞典

naive 的中文意思翻譯:adj. 幼稚的; 天真的; 單純的。naive的中文翻譯、naive的發音、柯林斯釋義、用法、naive的近義詞、反義詞和雙語例句等。 於 dictionary.liushengyingyu.com -

#32.naive中文(繁體)翻譯:劍橋詞典

naive 翻譯:輕信的;天真的;幼稚的。了解更多。 ... naive 在英語-中文(繁體)詞典中的翻譯. naive. adjective. mainly disapproving (also naïve, naïf). 於 dictionary.cambridge.org -

#33.AdGuard AdBlocker

Naive ad blocking would simply block ad servers, and leave broken elements and ... ไทย, العربية, 中文 (简体), 中文 (繁體), 日本語, 한국어. 於 chrome.google.com -

#34.論儒家哲學的三個大時代 - 第 181 頁 - Google 圖書結果

... 與價值混淆,《傳習錄》的讀者會發現,王陽明的唯心論的確是非常的幼稚(naive)。 ... London: Columbia University Press, 1963b), p. xxxiii,中文是由我翻譯的。 於 books.google.com.tw -

#35.naive翻譯及用法- 英漢詞典 - 漢語網

naive中文 的意思、翻譯及用法:adj. 天真的,幼稚的。英漢詞典提供【naive】的詳盡中文翻譯、用法、例句等. 於 www.chinesewords.org -

#36.大数据大家谈 - Google 圖書結果

Joint Naive Bayes and Lda for Unsupervised Sentiment Analysis [ C ] . ... [ 35 ]黄蔓菁,赵军,中文文本情感分析] .中国计算机学会通讯, 2008,4 ( 2 ) [ 36 ]刘小荣 ... 於 books.google.com.tw -

#37.The South Caucasus and the limits of Western power

This grouping has led to shortsighted policy approaches at times, but it is naive to expect the average policymaker in Washington or ... 於 www.brookings.edu -

#38.naive是什么意思? naive翻译(中文英文) - 抓鸟

naive 的解释是:天真的… 同时,该页为英语学习者提供:naive的中文翻译、英英详解、单词音标、在线发音、例句等。 於 dict.zhuaniao.com -

#39.請問too young too naive 是什麼意思? - 每天學英文單字

在網路上看到有網友的文章裡說到too young too naive 這句,感覺有點嘲諷意味,但不是很懂,請問誰知道這句too young too naive 是什麼意思? 於 www.englishday.cc -

#40.'naive' 的简体中文Translation | 柯林斯英语- 汉语词典 - Collins ...

'naive' 的简体中文Translation of | 官方柯林斯英语- 汉语词典网上词典。10 万条英语单词和短语的简体中文翻译。 於 www.collinsdictionary.com -

#41.the naive - OSCHINA - 中文开源技术交流社区

这是一个非常简单的Python 库,实现了朴素贝叶斯分类器。 示例代码: """ Suppose you have some texts of news and know their categories. 於 www.oschina.net -

#42.王力宏婚變啟發開騷談愛情觀張寶華對愛人扮naive 樂做簡單女人

當年向時任國家主席江澤民問及北京是否欽點特首董建華連任,被對方怒斥「Too simple, sometimes naive」成名,張寶華稱至今心態依然simple,難得 ... 於 news.mingpao.com -

#43.Pomegranates Original oil painting Art naive ... - Amazon.com

Pomegranates Original oil painting 9"x7" - 24x18cm by Roni Goldfinger. Naive art. Finger painting. Canvas board. Gift; Wall decor. US$30.00 ... 於 www.amazon.com -

#44.treatment-naive在線翻譯- 英語 - 海词词典

海詞詞典,最權威的學習詞典,為您提供treatment-naive的在線翻譯,treatment-naive是什麼意思,treatment-naive的真人發音,權威用法和精選例句等。 於 dict.cn -

#45.naive T cell | 科學Online - 國立臺灣大學

DNA引發過敏反應(Nucleic acid induces allergic inflammation) 國立臺灣大學生命科學系范姜文榮編譯/國立臺灣師範大學生命科學系李冠群副教授責任編輯. 於 highscope.ch.ntu.edu.tw -

#46.你是「天真」,「清純」還是「傻」,正確區分simple, naive ...

「天真」這個形容詞的中文含義常被引申為「單純、樸實、幼稚」,這可以用來形容人的品質和想法。那麼simple、naive、innocent 和pure 這幾個詞在英語 ... 於 kknews.cc -

#47.naive - Linguee | 中英词典(更多其他语言

大量翻译例句关于"naive" – 英中词典以及8百万条中文译文例句搜索。 ... Of course, I will not be so naive as to think that the Bill, after enactment, ... 於 cn.linguee.com -

#48.Microsoft 貝氏機率分類演算法

Microsoft Naive Bayes Algorithm ... 貝氏(Naïve Bayes) 名稱中的naïve 一字源自此演算法使用Bayesian 技術但卻沒有考量可能存在的相依性。 於 docs.microsoft.com -

#49.naive的中文意思- 释义、真人发音、例句 - 轻松背单词

naive. 级别, 第7级. 音标, [ naɪˈi:v ]. 解释, adj.幼稚的,轻信的;天真的. 英英释义, too willing to believe that someone is telling the truth , that people's ... 於 m.qsbdc.com -

#50.天真漫游记| UCCA尤伦斯当代艺术中心

语言: 国别配中文字幕. “我从童年的方向,看到的永远是你的背影,沿着通向君主的道路,你放牧乌云和羊群。雄辩的风带来洪水,胡同的逻辑深入人心,你 ... 於 ucca.org.cn -

#51.naive 的中文翻譯 - 英漢字典

naive (a.)天真的,純真的,樸素的. 於 cdict.net -

#52.Naive Bayes——Naive在哪? - 知乎专栏

Naive Bayes,中文译作朴素贝叶斯,这里Naive的原义是幼稚的,常常带有一点贬义的味道,用在这个算法命名中翻译为朴素,也称得上是一种包容了。 於 zhuanlan.zhihu.com -

#53.naive - Yahoo奇摩字典搜尋結果

天真的;幼稚的;輕信的. Dr.eye 譯典通 · naive · 查看更多. IPA[naɪˈiːv]. 美式. 英式. adj. 幼稚的;天真的. 牛津中文字典. naive. 天真的,純真的,樸素的. PyDict ... 於 tw.dictionary.yahoo.com -

#54.naive - 头条搜索

naive - 大沢誉志幸- 单曲- 网易云音乐 ... naive是什么意思|naive的音标|naive的用法- 英语词典 ... 大家都在搜. naive · simple翻译成中文 · 英文naive怎么读. 於 m.toutiao.com -

#55.A Comparative Vocabulary Study Guide: Spanish to Portuguese ...

... young, childish, naive Easily recognizable verbs and their Portuguese and ... 英语动词和他们的中文对等词 JURAR; jurar; to swear/pledge; fā shì:发誓, ... 於 books.google.com.tw -

#56.你问我答/ Simple, innocent, naive, pure 四个近义词的区别 - BBC

接下来让我们来看看naive,这是一个形容词。它常用来形容一个人太容易相信别人,以为所有人说的都是真话,或者每个人做事的意图都是好 ... 於 www.bbc.co.uk -

#57.Native-Land.ca | Our home on native land

Native Land is a resource to learn more about Indigenous territories, languages, lands, and ways of life. We welcome you to our site. 於 native-land.ca -

#58.naive是什麼梗?Too young too simple什麼意思介紹- 人人焦點

中文 意思是:太年輕,太簡單,有時幼稚。 總結起來就是:很傻很天真! 原標題:naive是什麼意思naive什麼梗. 責任編輯:曾少林 ... 於 ppfocus.com -

#59.+ Naive Day+ [naive_day] - P蝶 - Plurk

Profile views, 62187, Friends invited, 11. Plurks, 10323, Plurk responses, 101715. Member since: 2009-8-15, Last login, 2022-6-12 ... 於 www.plurk.com -

#60.naive - WordReference.com 英汉词典

主要翻译. 英语, 中文. naive adj, (not experienced: person) (人), SCSimplified Chinese 天真的,幼稚的,无知的,轻信的tiān zhēn de ,yòu zhì de ,wú zhī de ... 於 www.wordreference.com -

#61.naive只表示“天真”?被你的天真打败了! - 一线口语

一、naive不仅仅是“天真” · 1.无知的;轻信的. eg: Don't be so naive to trust him. He tells a pack of lies. · 2. 缺乏经验的;幼稚的 · 3. 天真的;率直 ... 於 www.e2say.com -

#62.Native Instruments - Software And Hardware For Music ...

2022 Native Instruments GmbH; Legal Information | Privacy Policy | Manage Cookies | Contact · English | Deutsch | 日本語 | Français | Español | 简体中文. 於 www.native-instruments.com -

#63.Angela Merkel's Limited Regrets - WSJ

The former German Chancellor says she wasn't naive about Putin. · Former German Chancellor Angela Merkel · Newsletter Sign-up. 於 www.wsj.com -

#64.naive BOTANICAL 綿密潔顏乳- 商品指南& 星評& 購物資訊

Naïve 的這款BOTANICAL綿密潔顏乳是「天然植物洗臉系列」的產品之一,凝聚了從世界各地精選而來的頂級橄欖油精萃。產品中還添加有日本瀨戶內海的小豆島生產的橄欖汁及 ... 於 www.gltjp.com -

#65.Naive Theory - 素樸理論 - 國家教育研究院雙語詞彙

舉例而言,麥克斯基(M. McCloskey)於一九八二年針對學生學習物理概念進行研究,此研究「運動的素樸理論」(naive theories of motion, ED223417)發現,學生認為經由彎曲 ... 於 terms.naer.edu.tw -

#66.Introduction to Surgically Naive (手術天真) | 學術寫作例句辭典

如何用「Surgically Naive」寫出專業的英文句子? 參考「Surgically Naive」學術論文例句,一次搞懂! 於 academic-accelerator.com -

#67.Naive B Cell Isolation Kit II, human - MiltenyiBiotec

The Naive B Cell Isolation Kit II was developed for the fast and efficient isolation of untouched naive B cells from human PBMCs. | Canada. 於 www.miltenyibiotec.com -

#68.naive (【形容詞】輕信的, 天真的, 幼稚的)意思- Engoo Words

如果形容一個大人是"a babe in the woods(森林裡的小嬰兒)",就代表他們很天真而且沒有自我保護的能力。 瀏覽教材. White - clean, sanitary, light, pure, naive. 於 engoo.com.tw -

#69.翻译'naive' – 字典中文-英文 - Glosbe

检查“ naive”到中文的翻译。浏览句子中naive的翻译示例,听发音并学习语法。 於 zh.glosbe.com -

#70.思維與語言 - 第 27 頁 - Google 圖書結果

時上第二,幼稚的心理( naive psychology )階段。該階段類似於幼稚的物理( naive physics )表現,亦即兒童對自己的身體和周圍的事物有了物理特性的經驗, ... 中文版譯序. 於 books.google.com.tw -

#71.初始B細胞- 维基百科,自由的百科全书

初始B細胞(naive B cell / virgin B cell)係一類還未與抗原接觸的B細胞。一旦與抗原接觸,它就會增殖分化爲記憶B細胞或者能產生能與刺激它的抗原特異性結合的抗體的 ... 於 zh.m.wikipedia.org -

#72.naive中文意思是什麼? 這裡有正確翻譯答案 - 選我正解-Wdnecy ...

提供英文單字naive的中文意思及正確翻譯包括詞性用法. 於 www.wdnecy.com -

#73.Biologic initiation rate in systemic-naïve PsA | OARRR - Dove ...

Biologic Initiation Rate in Systemic-Naïve Psoriatic Arthritis Patients Starting Treatment with Apremilast vs Methotrexate: 1-Year ... 於 www.dovepress.com -

#74.中文信息处理技术教程 - 第 286 頁 - Google 圖書結果

简述 Naive Bayes 分类方法的基本原理。. 6.简述 KNN 分类方法的基本原理。 7.简述 SVM 分类方法的基本原理。 8.简述决策树分类方法的基本原理。 9. 於 books.google.com.tw -

#75.Diplomacy is right even if it fails: Merkel defends Russian ...

... down six months ago, Ms Merkel overnight Tuesday insisted she had not been naive in her dealings with Russian President Vladimir Putin. 於 www.theaustralian.com.au -

#76.藥學中的naive patient 是什麼樣的病人? - GetIt01

還有,「treatment-naive」是什麼意思?如何恰當地翻譯?是指病人很簡單嗎?有答主提到是「此前未接受過治療」的病人,那麼是指僅僅未接受過所研究 ... 於 www.getit01.com -

#77.A SET OF SIX FRAMED VICTORIAN NAIVE DRAWINGS OF ...

Of two horses and four cows, all labelled to the reverse: EDWARD COLLINS, Born 5.4.1818 , together with a pair of coloured engravings of Hereford Bulls, ... 於 www.bonhams.com -

#78.Naive Auvidis - 博客來

取消確認. 選擇語言. English; 繁體中文; 简体中文. 全站分類 ... 您最近找過. Naive Auvidis. 影音 · 品牌總覽. Naive Auvidis. 篩選 排序 小圖 ... 於 www.books.com.tw -

#79.very naive 中文

Naive 另一个词: gullible, trusting, credulous, unsuspicious, green | 柯林斯 ... 博客School Scrabble 词库翻译器Quiz 数字资源More from Collins 英语英语– 中文. 於 www.ultimrls.me -

#80.NLP 入門(1) — Text Classification (Sentiment Analysis) — 極 ...

假設我們今天有3筆被標籤過的影評資料,我們想預測第四筆未知的影評,一起來在腦中建立一個Naive Bayes Classifer吧! 中文影評例子. 根據貝氏定理:. 從 ... 於 sfhsu29.medium.com -

#81.naive - 读音、用法- DictABC.COM

️︎︎2022❤️️︎︎】naive是什么意思、naive发音和在线翻译,naive怎么读,naive中文意思、读音、用法、例句、含义... 於 dictabc.com -

#82.naive 的中文翻釋|影音字典- VoiceTube 看影片學英語

超過400 萬人愛用的線上英語學習平台!上萬部YouTube 影片教材,搭配中英文翻譯字幕與英漢字典,輕鬆掌握日常對話、瞭解單字的發音與用法。是最適合華人提升英文聽力和 ... 於 tw.voicetube.com -

#83.Naive-Set-Theory

Naive -Set-Theory. □ □ 基礎的東西就是要特別練, 即使是routine的檢查一些性質, 這都是必要的操勞. □ 集合論, 數學之基礎, 不可不學也. 然後我一直沒好好趕工. 於 oz.nthu.edu.tw -

#84.naive - 从英语翻译成中文| PONS - 词典

在PONS在线词典中查找naive的英语中文对照翻译。包括免费词汇训练器、动词表和发音功能。 於 zh.pons.com -

#85.單字naive的中文意思與發音 - 線上字典

naive中文 意思: naive [na:'i:v] adj.天真的..., 學習naive發音, naive例句盡在WebSaru字典。 於 tw.websaru.info -

#86.包法利夫人(中文導讀英文版): 英語學習專家 克萊兒老師專業推薦

To show off, or from a naive imitation of this melancholy which called forth his, the young man declared that he had been awfully bored during the whole ... 於 books.google.com.tw -

#87.More from Warner Music Malaysia (KPOP/中文) - Facebook

時間戒不掉幼稚《幼稚未完》 如果要在「成熟地做人」與「幼稚地愛人」之間做選擇, 我選擇後者。 点击聆听 https://WMM.lnk.to/StillNaive. 於 m.facebook.com -

#88.naive是什么意思,naive怎么读,naive翻译为:幼稚的;天真的

naive 的中文意思:幼稚的;天真的;单纯,点击查看详细解释:naive的中文翻译、naive的发音、音标、用法和双语例句等,让你有效掌握naive这个单词。 於 fy.tingclass.net -

#89.免疫T細胞軍團靠得就是這4支具有不同功能小分隊 - Heho健康

... 後,才會離開胸腺進到二級淋巴組織成為等待與抗原結合的處女T細胞(naive T cell),而不能通過正負選擇任何一關的T細胞都會走向自我毀滅的道路。 於 heho.com.tw -

#90.尼斯Musee International d'Art Naif Anatole-Jakovsky (Museum ...

線上搜尋法國Musee International d'Art Naif Anatole-Jakovsky (Museum of Naive Art)附近的飯店。空房多、價錢優!線上預訂、到店付款。免預訂手續費。 於 www.booking.com -

#91.naive 中文

naive中文 的意思、翻譯及用法:adj. 天真的,幼稚的。英漢詞典提供【naive】的詳盡中文翻譯、用法、例句等英語釋義lacking experience of life; “ ... 於 www.redcana.me -

#92.lativ 米格國際

lativ 台灣網路服飾品牌,提供平價且高品質的衣服,線上可直接購買女裝、男裝、嬰兒裝、童裝、帆布鞋等。 於 www.lativ.com.tw -

#93.naive中文是什么意思 - 查查在线词典

naive 的中文意思:adj.天真的;自然的,朴素的;憨厚的。 ☆现在以写作na…,查阅naive的详细中文翻译、例句、发音和用法等。 於 www.ichacha.net